1. Bối cảnh Google ra mắt Gemini CLI mã nguồn mở

Gemini CLI là công cụ dòng lệnh (Command Line Interface) để truy cập và tích hợp các mô hình Gemini (thế hệ tiếp theo của Bard). Việc mã nguồn mở CLI này cho thấy Google đang đi theo hướng:

-

Khuyến khích nhà phát triển dễ dàng tích hợp AI của Google vào quy trình DevOps, pipelines hoặc các công cụ tự động hoá.

-

Tạo ra cộng đồng đóng góp xung quanh cách sử dụng Gemini (dù mô hình lõi vẫn không mã nguồn mở).

-

Tận dụng lợi thế hệ sinh thái Google Cloud + AI bằng cách mở đầu ra, nhưng vẫn giữ công nghệ lõi độc quyền.

💡 Điểm quan trọng: Google không open source mô hình Gemini, chỉ open source công cụ truy cập. Đây là chiến lược cân bằng giữa kiểm soát IP và mở rộng hệ sinh thái.

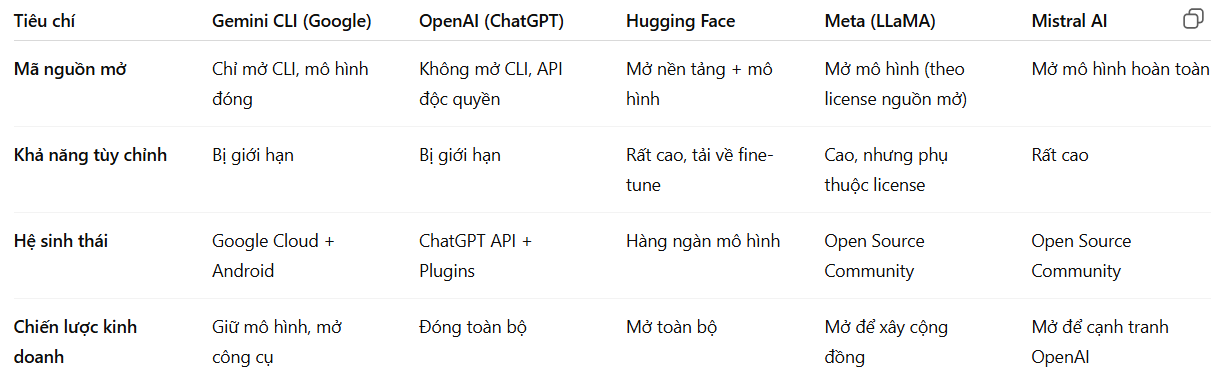

2. So sánh với các nền tảng AI mã nguồn mở khác

Điểm khác biệt:

-

Google vẫn bảo vệ chặt IP — chỉ mở công cụ tích hợp.

-

OpenAI thậm chí không mở công cụ truy cập.

-

Hugging Face, Meta, Mistral: mở hẳn mô hình và khuyến khích tuỳ biến.

-

Gemini CLI giống cách Microsoft hỗ trợ Copilot CLI — giúp DevOps dễ tích hợp hơn.

3. Nhận định xu hướng tương lai

Xu hướng 1: Hybrid Open Source

-

Các Big Tech như Google, OpenAI sẽ tiếp tục bán API, chỉ mở các công cụ SDK / CLI để mở rộng hệ sinh thái.

-

Các startup như Mistral, Meta sẽ đẩy mạnh mô hình mã nguồn mở thực sự để cạnh tranh.

-

Cộng đồng sẽ ngày càng ưu tiên mô hình mở + dễ tuỳ chỉnh (ví dụ LLaMA 3, Mistral 7B).

Xu hướng 2: Mở công cụ, đóng lõi

-

Sẽ phổ biến các Open SDK, CLI, Plugins, nhưng phần weights và training data vẫn đóng.

-

Mục tiêu: thu hút dev, nhưng tránh rò rỉ công nghệ lõi.

Xu hướng 3: Tập trung vào DevOps & Edge

-

CLI, SDK, API mở sẽ là chuẩn để AI tích hợp trong CI/CD, tự động hoá, on-premise.

-

AI không chỉ chạy trên đám mây, mà còn Edge AI, IoT, ứng dụng nhúng.

Xu hướng 4: Mô hình mở sẽ bùng nổ

-

Các doanh nghiệp sẽ chọn mã nguồn mở để:

-

Tránh lệ thuộc vendor lock-in.

-

Tối ưu chi phí inference.

-

Tự kiểm soát bảo mật, dữ liệu.

-

-

Do đó, Hugging Face và các bản LLM open-source vẫn sẽ phát triển mạnh.

Ý nghĩa chiến lược

Việc Google ra mắt Gemini CLI mã nguồn mở cho thấy một hướng đi thực dụng:

-

Họ không từ bỏ kiểm soát công nghệ lõi, vì mô hình Gemini vẫn là sản phẩm chiến lược, cạnh tranh trực tiếp với GPT-4, Claude hay LLaMA.

-

Tuy nhiên, Google hiểu rằng cộng đồng developer chính là đòn bẩy tăng trưởng — mở công cụ, mở SDK/CLI giúp mô hình Gemini dễ đi vào hạ tầng thực tế, chứ không chỉ nằm trong Google Cloud.

-

Đây là cách “mở ra để thu hút, đóng lại để kiểm soát” — mô hình lai (hybrid open source).

Nếu đặt trong bối cảnh thị trường:

-

OpenAI đang chọn đường đóng chặt, bảo vệ IP tối đa, dùng sức mạnh hạ tầng (Azure + Copilot).

-

Meta, Mistral, Hugging Face lại chọn đường mở mô hình, xây cộng đồng mạnh, chia sẻ weights, tập trung democratize AI.

-

Google chọn thế trung gian: không mạo hiểm như Meta (LLaMA), không khép kín như OpenAI — mà giữ mô hình, mở công cụ.

Tác động dài hạn

Trong dài hạn, cách tiếp cận này sẽ:

-

Tăng tính phụ thuộc vào Google Cloud nếu doanh nghiệp tích hợp Gemini CLI sâu trong DevOps/CI/CD.

-

Đẩy nhanh hệ sinh thái plugin/extension chạy trên Gemini, giúp Google cạnh tranh ChatGPT Plugins hay Copilot Extensions.

-

Tuy nhiên, mặt trái là:

-

Developer sẽ ngày càng tìm mô hình thật sự mở để fine-tune on-premise, vì yếu tố chi phí và dữ liệu nhạy cảm.

-

Các chính phủ, doanh nghiệp lớn, tổ chức nghiên cứu sẽ ưu tiên mô hình mở để kiểm soát tốt hơn về bảo mật.

-

Nói cách khác: Google đang chơi ván bài hệ sinh thái, nhưng sức ép từ cộng đồng mã nguồn mở sẽ không biến mất — mà sẽ tăng lên, nhất là khi chi phí chạy mô hình mở ngày càng rẻ.

Khuyến nghị

✅ Đối với doanh nghiệp & CTO:

-

Hãy coi Gemini CLI như một công cụ tích hợp nhanh, tiện lợi, nhưng đừng bỏ qua kịch bản song song: chuẩn bị hạ tầng multi-cloud, multi-model (kết hợp API đóng + mô hình mở như Mistral, LLaMA).

-

Tính toán kỹ chi phí API vs self-hosted, đặc biệt với workloads lớn hoặc dữ liệu nhạy cảm.

✅ Đối với developer:

-

Khai thác CLI để tự động hoá, prototyping nhanh.

-

Tuy nhiên, nên tìm hiểu cách deploy mô hình mã nguồn mở để tránh bị khóa chặt (vendor lock-in) khi quy mô mở rộng.

✅ Đối với cộng đồng AI:

-

Việc Google “bán mở” cho thấy mã nguồn mở vẫn là con đường cạnh tranh thực sự.

-

Sự phát triển của các community-driven LLM (Hugging Face, Mistral) sẽ giúp cân bằng thế độc quyền.